- 現在位置

- トップ > 白書・統計・出版物 > 白書 > 科学技術・イノベーション白書 > 令和6年版 科学技術・イノベーション白書 > 令和6年版科学技術・イノベーション白書 本文(HTML版) > 第1章 新時代を迎えたAI

第1章 新時代を迎えたAI

第1節 AIとは

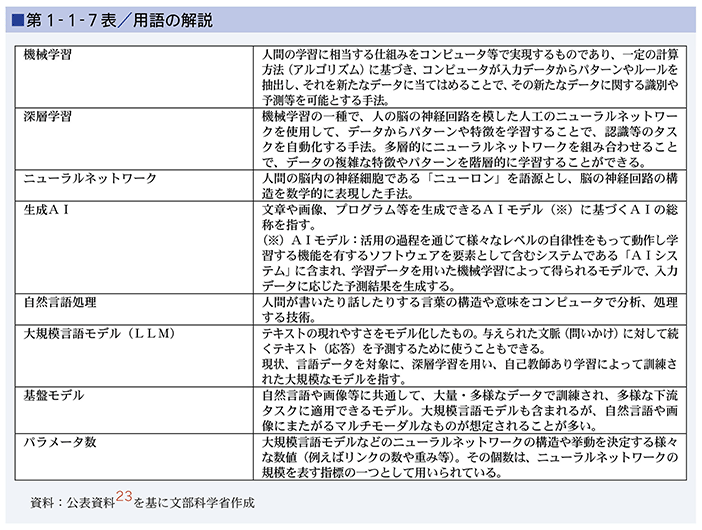

AIとは人工知能(Artificial Intelligence)の略称です。AIという言葉は、1955年に米国の計算機科学研究者ジョン・マッカーシー博士が作った言葉で、ダートマス会議(1956年)の開催提案書の中で使われました(※1)。AIについては、いまだ国際的に合意された定義はありませんが(※2)、人間の思考プロセスと同じような形で動作するプログラム、あるいは人間が知的と感じる情報処理・技術といった広い概念で理解されています。近年、様々な新しい技術とコンピュータの性能が大きく向上したことにより、機械であるコンピュータが「学ぶ」ことができるようになりました。それが現在のAIの中心技術となっている「機械学習」です。機械学習の進展により、翻訳や自動運転、医用画像診断といった人間の活動に、AIが大きな役割を果たしつつあります。

第2節 AI技術の潮流(※3)

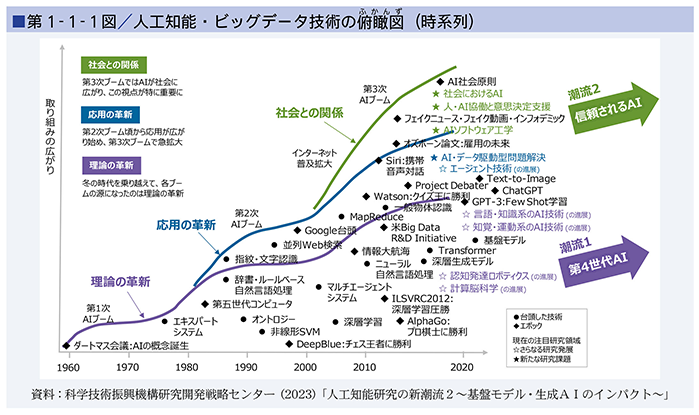

AI技術のこれまでの進展を振り返ると、第1-1-1図の俯瞰図(ふかんず)のように、幾度もブームを繰り返しながら、研究開発の取組が広がってきています。

1950年代後半から1960年代に起きた「第1次ブーム」では、AIに関する基礎的な概念が提案され、新しい学問分野として立ち上がりました。1966年には米国マサチューセッツ工科大学人工知能研究所のジョセフ・ワイゼンバウム博士により、初の対話型自然言語処理プログラム「ELIZA」が開発されました。ELIZAは、人間の入力文に対する簡単なパターンマッチによって応答を返すシステムで、現在のチャットボットの先駆けともなっています。

1980年代から1990年代に起きた「第2次ブーム」では、人手で辞書・ルールを構築・活用する手法が主流となり、エキスパートシステム、辞書・ルールベース自然言語処理などの実用化にもつながりましたが、人手による限界などから、一度ブームは終息しました。

そして、2000年代以降の技術の進展に伴うインターネットや計算能力の拡大を背景として、大量のデータから帰納的にルールやモデルを構築する「機械学習」技術の進展等によって、2010年頃から「第3次ブーム」が牽引(けんいん)されてきましたが、さらに最近の生成AI技術の進展等を受けて、現在は「第4次ブーム」に差し掛かっているとも言われています。

機械学習技術には、様々な「モデル」と「学習法」があります(※4)が、特に近年発展してきているモデルは、人間の脳の神経細胞(ニューロン)が回路網を形成して情報伝達している仕組みを参考に作られた、人工ニューロンのネットワーク(ニューラルネットワーク)を多層化・大規模化して用いる「深層学習」です。このニューラルネットワークのモデルは1960年前後に活発に研究され、1980年頃には深層学習につながる研究もなされていましたが、近年になってようやく、計算機の性能向上や利用可能なデータ量の増大とあいまって、急速に技術の発展が進み、2015年には深層学習を用いたGoogle DeepMind社の「AlphaGo」が、世界トップクラスの囲碁棋士に勝利したことも発表されました。

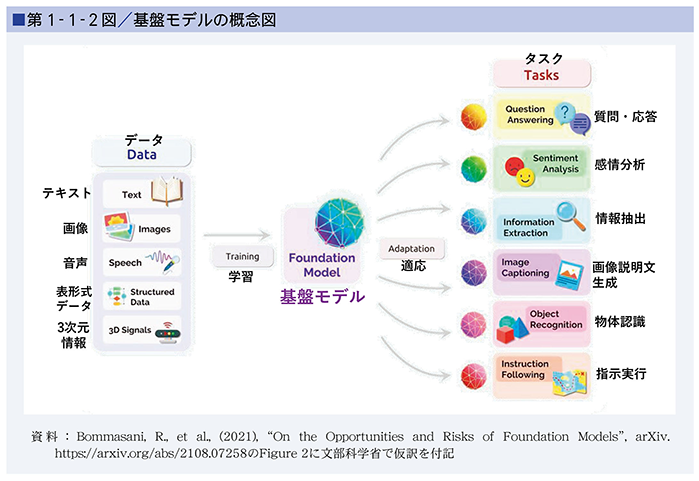

深層学習には、非常に大きな計算機が必要と考えられていましたが、グラフィックスの描画に用いられていたプロセッサ(GPU(※5))を計算に用いることで、深層学習の研究開発も大きく進展しました。また、機械学習の学習法としては主に「教師あり学習」、「教師なし学習」、「強化学習」(※6)がありますが、2020年前後から関心の高まっている画像生成や対話型のAIなどの「生成AI(Generative AI)」では「自己教師あり学習(※7)」が用いられています。このうち、近年、「大規模言語モデル(LLM(※8))」と呼ばれる、言語を中心とした深層学習モデルの研究が飛躍的に進みました。中でも、自然言語で指示や条件(プロンプト)を与えることができる「対話型生成AI」は、利用者との対話において自然で流暢(りゅうちょう)な文章を生成することができ、またインターネット上で使えるサービスが提供されたことから、研究者や技術者だけでなく、一般の人々の仕事や生活での利用も急速に広がりました。OpenAI社によって開発された「GPT(※9)シリーズ」のモデルを利用した対話型のAIサービス「ChatGPT」は、2022年11月公開後、我が国でも急速に利用が広がりました(※10)。また、2022年以降、テキストから画像を生成する画像生成AIモデルをインターネット上で使える様々なサービスも公開されています(※11)。さらに、言語や画像等の複数のモダリティ(データの種類)も対応付けられ、マルチモーダル性(※12)・汎用性の高い「基盤モデル(※13)」の研究も進められています(第1-1-2図)。

なお、AIは、その研究や開発の過程において、適用範囲や能力により、大きく二つのカテゴリに分けることができます。特定の機能や特定の状況下でのみ人間に近く、時には精度で人間を上回る動作をする「特化型AI」と、人間の知能の様々な側面を幅広くカバーし、様々な状況で人間の知能のように動作する汎用性の高いシステム(「汎用AI(AGI(※14))」)です。第3次ブームにおいて、様々な応用に広がったAI技術は基本的に「特化型AI」に相当する技術群とされていますが、極めて大規模な深層学習によって作られた「基盤モデル」の登場により、研究開発の中心がこれまでの特化型AIと言われていたものから、高いマルチモーダル性・汎用性を持つAIへと向かいつつあります。

このように、生成AIに関する技術の進展や、技術者や専門家でなくてもインターネット上で自然言語を用いて利用できるようになってきていることなどにより、今後、生成AI技術を活用したアプリケーションに関する市場が拡大するとともに、製造業をはじめとする様々な産業分野での活用が広がっていくと見込まれています(※15)。

第3節 生成AI技術の飛躍的な進展をもたらした技術的な要因と次世代技術の方向性

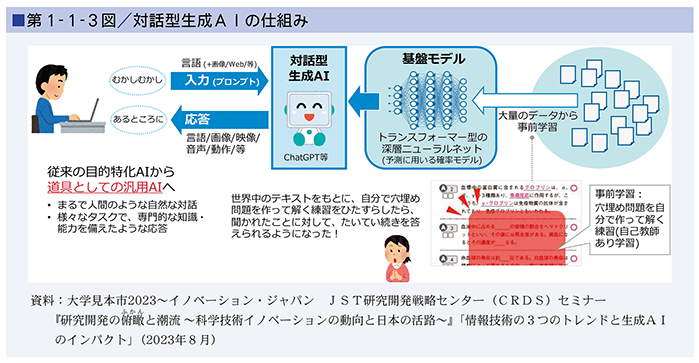

ChatGPTのような「対話型生成AI」技術が急速に普及した要因としては、自然言語をインターフェースとし、インターネット上で使える形で提供されたことに加えて、技術的な面で超大規模学習が進められ、予測精度が大幅に向上したことが挙げられます。

例えば、2014年にカナダのモントリオール大学の研究者らによって発表された「敵対的生成ネットワーク(※16)」により、少ないデータから学習に必要なデータを作り出し、高精度の結果を出すことが可能となりました。また、高性能計算機の普及により、大量の計算を高速に行うことが可能となりました。

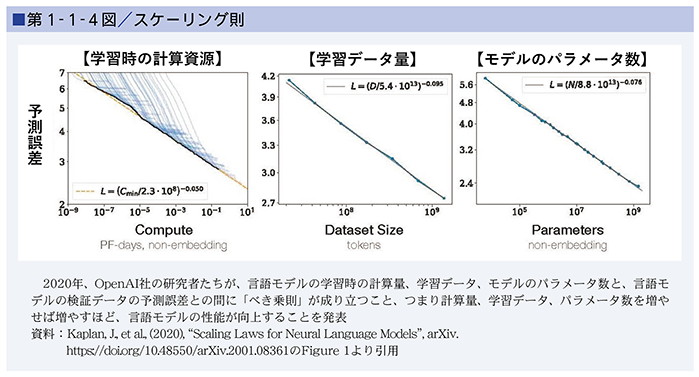

また、ニューラルネットワークの中のどこに注目するか自体を自動的に学習することができる手法(自己注意機構)を活用した「トランスフォーマー」と呼ばれる深層学習モデルが、2017年にGoogle社の研究者によって発表され(※17)、タスクを特定しない形の事前学習で、従来より効率性や汎用性が高いモデルを構築することが可能になりました。さらに、それまで主流だった「教師あり学習」に代わり、データから擬似的な教師データ(正解ラベル)を自動的に作って「教師あり学習」を行う「自己教師あり学習」のアプローチが進みました。例えば、2018年にGoogle社から発表された「BERT(※18)」では、元のテキストの複数箇所を隠して訓練するという方法が導入され、人間による正解の生成が必要なくなり、大規模学習が可能になりました(第1-1-3図)。このような中、2020年には、大量のデータを学習させてモデルの規模を巨大化するほど、予測精度が向上すること(スケーリング則)(※19)が確認されたことで(第1-1-4図)、モデルの超大規模化に向けた研究開発が急速に進められました。

画像生成についても、前述の「敵対的生成ネットワーク」により、精巧な画像の生成が可能になるとともに、2015年に発表された「拡散モデル(※20)」、さらに2020年に発表された「ノイズ除去拡散確率モデル(※21)」などにより、高精度な画像生成が可能になり、自然言語の条件(プロンプト)入力で、画像の生成ができるようになりました。

また、AIを人間や社会の価値観に整合した振る舞いをするようにする仕組み(AIアライメント)の開発が進んだことも、要因の一つとして挙げられます。2016年3月に、Microsoft社の会話するAI(チャットボット)の「Tay」が、悪意を持ったユーザーとの対話によって、瞬く間に差別的な発言を行うようになり、サービス提供開始後約16時間で利用停止となりました(※22)が、ChatGPTでは、人間のフィードバックを用いた強化学習によって基盤モデルが調整(チューニング)されるなどの対策が講じられています。

このような目覚ましい技術の発展の一方で、技術的な課題も多く残されています。学習に用いるデータ量や計算資源が増え続け、それに伴う消費電力量も増加している点に加えて、対話型生成AIは、統計的に次の言葉を予測しているに過ぎず、意味を理解して回答しているということではないため、数式計算や物理法則に基づく予測のような論理推論に弱いことも指摘されています。

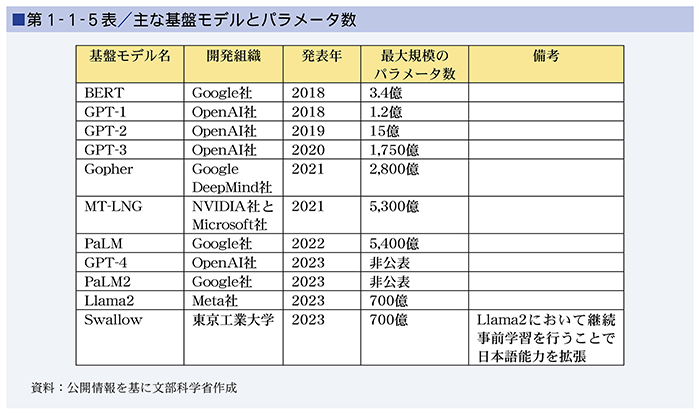

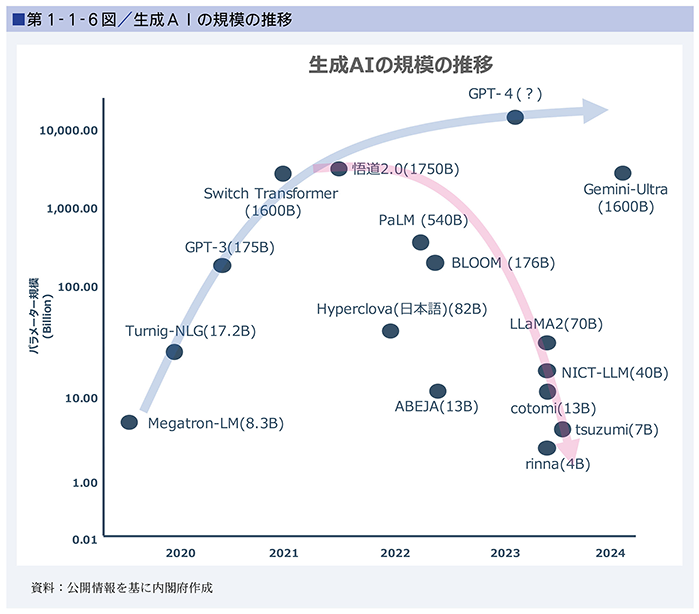

このような課題の解決に向けて、次世代AIの研究開発が始まっています。現在の深層学習のようなデータからボトムアップでルールやモデルを構築する帰納型の仕組みだけでなく、トップダウンで知識やルールを与え、状況や文脈に応じてそれらを組み合わせ、解釈・推論するような演繹(えんえき)型の仕組みについての研究開発も取り組まれています。また、前述のとおり、大量のデータを学習することで、高い精度での生成が可能になるとされているものの、学習データの規模が小さくても、質が高いデータを学習することにより、高効率で高性能なモデルの開発を目指す取組もなされています(第1-1-5表、第1-1-6図)。

コラム1-1 AIとは何か

AIやAIシステムについては、各国政府・国際機関等はそれぞれが公表文書や法令において、その用語の意味を解説していますが、現時点で確立された統一的な定義はありません。

我が国においては、令和6年(2024年)4月に策定された「AI事業者ガイドライン第1.0版」で、日本産業規格(JIS)の定義も参考に、AIシステムを「活用の過程を通じて様々なレベルの自律性をもって動作し学習する機能を有するソフトウェアを要素として含むシステム(機械、ロボット、クラウドシステム等)」とし、AIは「AIシステム自体又は機械学習をするソフトウェア若しくはプログラムを含む抽象的な概念」としています。また、米国や欧州も、機械ベース(machine-based)のシステムであるとしています(※24、※25)。

ほかにも2023年11月、OECDは、技術の進展を踏まえ、2019年に発表した「AI原則」の中における「AIシステム」の定義を更新し「AIシステムは、明示的又は暗黙的な目的のために推測する機械ベースのシステムである。受け取った入力から、物理環境又は仮想環境に影響を与える可能性のある予測、コンテンツ、推奨、意思決定等の出力を生成する。AIシステムが異なれば、導入後の自律性及び適応性のレベルも異なる。」(仮訳)としています(※26)。このように、技術の進展に応じた柔軟な定義付けも必要になってきています。

- ※1 McCarthy, J., et al., (2006), “A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, August 31, 1955”, AI Magazine 27, 12-14.

https://doi.org/10.1609/aimag.v27i4.1904 - ※2 コラム1-1のとおり、各国・地域では「AI」や「AIシステム」について様々な定義がなされているが、日本産業規格(JIS)においては、「人工知能システム、AIシステム」とは、「人間が定義した所与の目標の集合に対して、コンテンツ、予測、推奨、意思決定などの出力を生成する工学的システム」と定義されている。

- ※3 本節をはじめ第1部については、複数箇所で、科学技術振興機構研究開発戦略センター(2023)「人工知能研究の新潮流2~基盤モデル・生成AIのインパクト~」、及び同(2024)「次世代AIモデルの研究開発」を参照した。

- ※4 杉山将(2024)「教養としての機械学習」東京大学出版会

- ※5 Graphics Processing Unit

- ※6 「教師あり学習」は正解のラベルを付けた学習データで学習する手法、「教師なし学習」は正解のラベルを付けない学習データにより学習するモデル、「強化学習」は一定の環境の中で試行錯誤を行い、報酬を与えることにより学習するモデル(令和元年版情報通信白書等参照)。

- ※7 「自己教師あり学習」は、データから擬似的な教師データ(正解ラベル)を自動的に作って「教師あり学習」を行う手法。

- ※8 Large Language Models

- ※9 Generative Pre-trained Transformer

- ※10 株式会社野村総合研究所(2023)「日本のChatGPT利用動向(2023年6月時点)」

https://www.nri.com/jp/knowledge/report/lst/2023/cc/0622_1 - ※11 総務省(2023)「令和5年版情報通信白書」

https://www.soumu.go.jp/johotsusintokei//whitepaper/ja/r05/html/nd131310.html - ※12 マルチモーダルは、テキスト、音声、画像、動画、センサー情報など、二つ以上の異なるモダリティ(データの種類)から情報を収集し、それらを統合して処理すること。

- ※13 Bommasani, R., et al., (2021), “On the Opportunities and Risks of Foundation Models”, arXiv.

https://arxiv.org/abs/2108.07258 - ※14 Artificial General Intelligence

- ※15 一般社団法人電子情報技術産業協会(2023)「注目分野に関する動向調査2023」みずほ銀行産業調査部(2023)「みずほ産業調査Vol.74 No.2【革新的技術シリーズ】生成AIの動向と産業影響~生成AIは産業をどのように変えるか~」

- ※16 Generative Adversarial Networks(GAN)

- ※17 Vaswani, A., et al., (2017), “Attention Is All You Need”, arXiv.

https://arxiv.org/abs/1706.03762 - ※18 Bidirectional Encoder Representations from Transformers

- ※19 Kaplan, J., et al., (2020), “Scaling Laws for Neural Language Models”, arXiv.

https://doi.org/10.48550/arXiv.2001.08361 - ※20 Diffusion Model Sohl-Dickstein, J., et al., (2015), “Deep Unsupervised Learning using Nonequilibrium Thermodynamics”, arXiv.

https://arxiv.org/abs/1503.03585 - ※21 Denoising Diffusion Probabilistic Models(DDPM)Ho, J., et al., (2020), “Denoising Diffusion Probabilistic Models”, arXiv.

https://arxiv.org/abs/2006.11239 - ※22 Microsoft社(2016)“Learning from Tay's introduction”

https://blogs.microsoft.com/blog/2016/03/25/learning-tays-introduction/ - ※23 内閣府「AI戦略会議」

総務省、経済産業省(2024)「AI事業者ガイドライン第1.0版」

科学技術振興機構研究開発戦略センター(2023)「人工知能研究の新潮流2~基盤モデル・生成AIのインパクト~」

みずほ銀行産業調査部(2023)「みずほ産業調査Vol.74 No.2【革新的技術シリーズ】生成AIの動向と産業影響~生成AIは産業をどのように変えるか~」等を参照 - ※24 The White House (2023), “Executive Order on the Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence”.

https://www.whitehouse.gov/briefing-room/presidential-actions/2023/10/30/executive-order-on-the-safe-secure-and-trustworthy-development-and-use-of-artificial-intelligence/ - ※25 European Parliament (2024), “Artificial Intelligence Act”.

https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138_EN.pdf - ※26 OECD (2024), “Explanatory memorandum on the updated OECD definition of an AI system”.

https://www.oecd.org/science/explanatory-memorandum-on-the-updated-oecd-definition-of-an-ai-system-623da898-en.htm

お問合せ先

科学技術・学術政策局研究開発戦略課